Serviços Personalizados

Journal

Artigo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Acessos

Acessos

Links relacionados

-

Similares em

SciELO

Similares em

SciELO

Compartilhar

Revista Portuguesa de Educação

versão impressa ISSN 0871-9187

Rev. Port. de Educação vol.31 no.2 Braga dez. 2018

https://doi.org/10.21814/rpe.14105

O Bom Leitor: Preditores da Literacia de Leitura dos Alunos Portugueses no PIRLS 2016

The good reader: predictors of portuguese students’ reading literacy in the Pirls 2016

Le bon lecteur : predicteurs de la lecture des éleves portugais dans le pirls 2016

João Marôcoi

iInstituto Superior de Psicologia Aplicada - Instituto Universitário, Portugal

Endereço para Correspondência

RESUMO

Em 2016, 4642 alunos portugueses, selecionados aleatoriamente de todas as regiões de Portugal, a frequentar o 4.º ano de escolaridade em escolas públicas e privadas, participaram no PIRLS 2016, tendo alcançado um desempenho médio de 528 pontos (SE = 2,3), 13 pontos significativamente abaixo da média observada no PIRLS 2011. Neste artigo, por recurso a modelos de regressão linear hierárquica aplicados aos valores plausíveis de literacia dos alunos, procurou-se identificar as variáveis ao nível do aluno, das famílias, dos professores e das escolas capazes de explicar a variabilidade observada nos resultados de literacia de leitura dos alunos portugueses. Cerca de 26% e 32% desta variabilidade podem, respetivamente, ser explicadas por um conjunto reduzido de variáveis caracterizadoras do aluno e da família, e dos professores e das escolas. A confiança dos alunos como leitores e os recursos educativos disponíveis em casa são os melhores preditores da variação dos desempenhos ao nível do aluno e família. Ao nível da escola e dos professores, a ênfase da escola no sucesso académico e a perceção dos professores quanto à vontade de os alunos terem sucesso académico são os melhores preditores da variação observada nos desempenhos dos alunos portugueses no PIRLS 2016.

Palavras-chave: PIRLS; Literacia de leitura; Preditores de desempenho; Regressão linear hierárquica

ABSTRACT

In 2016, 4642 Portuguese students, randomly selected from all Portuguese regions, attending fourth grade in public and private schools, participated in the PIRLS 2016. In this edition, Portuguese students achieved an average performance of 528 points (SE = 2.3), 13 points significantly below the average observed in PIRLS 2011. In this paper, using hierarchical linear regression models applied to the students' plausible values of literacy, variables at the students’ and the families’ level and at the teachers’ and the schools’ levels are identified that can better explain the variability observed in the PIRLS 2016 reading literacy. About 26% and 32% of this variability can, respectively, be explained by a reduced set of variables characterizing the student and their family, and teachers and schools. At the student and family level, student confidence as readers and the educational resources available at home are the best predictors of students’ performance variation. At the school and teacher level, the school's emphasis on academic success and teachers 'perceptions of students' willingness to succeed academically are the best predictors of the observed variation of the Portuguese students’ performance in PIRLS 2016.

Keywords: PIRLS; Reading literacy; Predictors of achievement; Hierarchical linear regression

RÉSUMÉ

En 2016, 4642 étudiants Portugais, sélectionnés au hasard dans toutes les régions Portugaises, fréquentant la 4ème année de scolarité dans les écoles publiques et privées, ont participé au PIRLS 2016. Dans cette édition, les élèves nationaux ont obtenu une performance moyenne de 528 points (SE = 2,3), soit 13 points de moins que la moyenne observée dans PIRLS 2011. Dans cet article, en utilisant des modèles de régression linéaire hiérarchique appliqués aux valeurs plausibles de la littéracie de lecture, nous avons tenté d'identifier les variables au niveau de l'élève, des familles, des enseignants et des écoles capables d'expliquer la variabilité observée dans les résultats de la littéracie de lecture d'étudiants Portugais. Environ 26% et 32% de cette variabilité peuvent, respectivement, s'expliquer par un ensemble réduit de variables caractérisant l'élève et la famille, les enseignants et les écoles. Au niveau de l'apprenant et de la famille, la confiance des élèves en tant que lecteurs et les ressources éducatives disponibles à la maison sont les meilleurs prédicteurs de la variation du rendement des élèves. Au niveau de l'école et de l'enseignant, l'accent mis par l'école sur la réussite scolaire et la perception des enseignants de la volonté des élèves de réussir sur le plan scolaire sont les meilleurs prédicteurs de la variation observée dans la performance des élèves Portugais dans PIRLS 2016.

Mots-clés:Littéracie de lecture; Prédicteurs de la performance ; Régression linéaire hiérarchique

Introdução

Saber ler e compreender o que se lê são competências fundamentais ao desenvolvimento e maturação intelectual das crianças nas sociedades contemporâneas caracterizadas pela livre circulação da informação. Consciente da importância da leitura na sociedade, a International Association for the Evaluation of Educational Achievement (IEA) – uma cooperativa de institutos, agências governamentais e agências não governamentais que desenvolvem investigação/intervenção em educação – promove, desde 2001, o estudo Progress in International Reading Literacy Study (PIRLS). O PIRLS é um projeto colaborativo entre os países participantes e a IEA, sob direção do TIMSS & PIRLS International Study Center do Boston College. O estudo avalia a literacia de leitura em papel, por amostragem em larga escala, em crianças com quatro anos de escolaridade formal. A IEA define literacia de leitura como sendo a “capacidade para compreender e usar as formas de linguagem escrita requeridas pela sociedade e/ou valorizadas pelo indivíduo” (Mullis, Martin, & Sainsbury, 2015, p. 11).

O quadro de referência do PIRLS enfatiza o uso da leitura com dois objetivos principais: i) experiência literária e ii) aquisição e utilização de informação (Mullis et al., 2015). Assim, uma criança com competências de literacia de leitura consegue atribuir sentido a textos em diferentes formatos. Lê para aprender, para participar em comunidades de leitores na escola e no dia a dia e também lê por prazer. A idade dos alunos avaliados pelo PIRLS – 9-10 anos – reforça a importância da literacia de leitura nos sistemas educativos modernos. Até esta idade, a criança aprende a ler; a partir daí, lê para aprender (Martin, Mullis, & Foy, 2017). É, pois, fundamental que à saída do 1.º ciclo do ensino básico as crianças sejam leitoras competentes. A importância do desenvolvimento destas competências no percurso escolar dos alunos é por demais enfatizada. Ainda recentemente, Rodrigues, Alçada, Calçada, e Mata (2017) identificaram o défice de competências de leitura como a primeira causa de repetência precoce (no 2.º ano do 1.º ciclo do ensino básico) em Portugal.

Além da avaliação da literacia de leitura propriamente dita, o estudo PIRLS recolhe, com recurso a uma série de questionários, informação sobre os alunos e suas famílias, sobre os professores e escolas (Hooper, Mullis, & Martin, 2015). Esta informação permite caracterizar as oportunidades, as estratégias e os contextos de aprendizagem de leitura, bem como identificar variáveis que podem influenciar esta aprendizagem. Ao avaliar as competências de leitura e os contextos onde esta se desenvolve, o PIRLS permite o diagnóstico das áreas educativas, socioeconómicas e culturais nas quais os sistemas educativos podem investir de forma a que a leitura seja uma ferramenta eficaz na aquisição do conhecimento e na cidadania ativa. O desenvolvimento, no quadro de referência do PIRLS, dos testes e dos questionários de contexto social, económico e cultural aos alunos, famílias, professores e escolas resulta de um trabalho colaborativo entre grupos de especialistas da IEA e os coordenadores nacionais do projeto. Os coordenadores nacionais compilam a informação sobre os sistemas educativos de cada um dos respetivos participantes, plasmada na Enciclopédia do PIRLS, de forma a caracterizar e enquadrar os sistemas educativos dos países participantes no estudo (Mullis, Martin, Goh, & Prendergast, 2017). A natureza colaborativa do PIRLS, e as diferentes validações técnicas nos procedimentos de tradução, adaptação e aplicação dos testes e questionários, bem como os métodos de amostragem e de estimação da literacia, devidamente ancorados nos resultados de edições anteriores do PIRLS, asseguram que os resultados em cada edição do estudo apresentem validade transcultural, devidamente enquadrada nos diferentes contextos e curricula nacionais, validade concorrente e fiabilidade (Mullis, Martin, Goh et al., 2017).

O PIRLS em conjunto com o TIMSS, que avalia literacia de matemática e literacia de ciências, são a mais extensa avaliação internacional dos conhecimentos e competências dos alunos de todo o mundo a frequentar o 4.º ano de escolaridade. Sob a égide da IEA, os resultados do TIMSS e do PIRLS “have contributed to the practice of evidence-based decision making in today’s shifting landscape of education policy”(Mullis, 2016).

A descida significativa de 13 pontos na média nacional do PIRLS 2016, comparativamente à média do PIRLS 2011, foi recebida com algum desencanto pelos stakeholders da educação nacional. Os resultados negativos e possíveis preditores do fraco desempenho dos alunos portugueses no PIRLS 2016 foram divulgados e amplamente debatidos na comunicação social (ver, por exemplo, Viana, 2017). Os dados do PIRLS permitem, mais do que uma análise das causas de resultados menos bons, identificar as variáveis que fazem – à luz do PIRLS – um bom leitor. Neste artigo, procura-se, recorrendo a uma análise hierárquica dos resultados de literacia e das variáveis de contexto organizacional, socioeconómico e cultural dos alunos, famílias, professores e escolas, identificar os preditores com maior poder explicativo da variação dos desempenhos dos alunos nacionais no PIRLS 2016.

Método

Participantes

No PIRLS 2016, participaram 4642 alunos portugueses de ambos os sexos a frequentar o 4.º ano de escolaridade no ano letivo de 2015/2016. Estes alunos foram selecionados por um processo de amostragem aleatória multi-etapa, como definido pelo consórcio da IEA-Boston College responsável pelo PIRLS 2016 (Martin, Mullis, & Foy, 2017). Na primeira etapa, foi feita a estratificação do território nacional nas regiões definidas pela «Nomenclatura das Unidades Territoriais para Fins Estatísticos» de nível III (NUTS III) [1]. Na segunda etapa, 220 agrupamentos de escolas/escolas não agrupadas, quer públicas quer privadas, com alunos a frequentar o 4.º ano de escolaridade com o currículo nacional do ensino básico, foram selecionados por amostragem sistemática (das 220 escolas selecionadas, 218 participaram no estudo)(Mullis, Martin, Foy, & Hooper, 2017). Finalmente, em cada escola selecionada foi extraída uma amostra aleatória de uma ou duas turmas de 4.º ano, em função do número e da dimensão das turmas em cada escola selecionada. Foram testados todos os alunos das turmas selecionadas que cumpriam os critérios de elegibilidade para o PIRLS (não terem necessidades educativas especiais, certificadas pelas entidades competentes, que impossibilitassem a realização do teste ou questionário; terem como língua materna o português ou mais de um ano de aprendizagem da língua) e cuja participação foi autorizada pelos encarregados de educação. A idade média dos alunos participantes foi de 9,8 anos (SD = 0,01) sendo 51% do sexo masculino. A taxa de amostragem das escolas e dos alunos foi de 5% (Mullis, Martin, Foy et al., 2017).

Instrumentos e Procedimentos

Testes PIRLS

A avaliação da literacia de leitura no PIRLS 2016 foi realizada por um conjunto de tarefas de leitura organizadas em 16 cadernos de teste. Cada caderno apresentou um texto literário e um texto informativo, seguidos de um conjunto de itens de seleção e itens de construção que avaliaram a literacia de leitura e as suas dimensões (finalidades de leitura e processos de compreensão) (Mullis & Prendergast, 2017). Cada aluno participante respondeu a um dos 16 cadernos de teste, de acordo com um delineamento definido previamente pelo consórcio da IEA-Boston College e a um questionário sociodemográfico (ver Martin et al., 2017b para maior detalhe). A tradução e adaptação dos testes, a partir dos originais em inglês, foi realizada por profissionais com experiência de ensino da língua portuguesa e com conhecimento certificado da língua inglesa. A validade das traduções e adaptações foi verificada por uma agência de tradução independente subcontratada pela IEA (Ebbs & Wry, 2017).

A aplicação dos testes, em datas acordadas com as escolas, teve lugar em fevereiro de 2016 e foi feita por profissionais previamente treinados. Estes seguiram um guião de aplicação (com os tempos de testagem, instruções para a realização do teste e dos questionários e verificação dos alunos selecionados) comum a todos os países participantes. A duração do teste foi de 80 minutos, com um intervalo não superior a 30 minutos no final dos primeiros 40 minutos. No final do teste, foi aplicado o questionário sociodemográfico com duração de 20 minutos (Johansone, 2017).

As respostas aos itens de construção [2] foram codificadas por um painel de professores, com treino específico para a função, de acordo com um guião de codificação produzido pelo consórcio da IEA-Boston College e utilizado em todos os países. A fiabilidade inter-codificadores foi controlada pelo mesmo consórcio.

Questionários PIRLS

Paralelamente aos testes, o estudo PIRLS é constituído por uma série de questionários aos diretores da escola, aos professores das turmas selecionadas, aos encarregados de educação e aos alunos. A partir das respostas aos questionários, o consórcio da IEA-Boston College produziu um conjunto de índices e de escalas psicométricas que permitem caracterizar as perceções e opiniões dos alunos, diretores de escolas, professores e encarregados de educação relativamente ao contexto escolar, profissional e sociodemográfico dos elementos da comunidade escolar (Hooper & Fishbein, 2017). De entre as dezenas de índices e escalas apresentadas no relatório internacional [3], aquelas que apresentam maior poder preditor no modelo linear hierárquico (a ver na secção dos resultados) são descritas a seguir.

Confiança como leitor

Esta escala é uma medida psicométrica que avalia a confiança do aluno nas suas competências de leitura. A escala é operacionalizada a partir do grau de concordância do aluno (de Concordo completamente’ a Discordo completamente’) relativamente a seis afirmações sobre o quão bom se considera na leitura (por exemplo, “Normalmente, sou bom na leitura” ou “Para mim, a leitura é mais difícil do que qualquer outra matéria”).

Recursos Educativos em Casa

Esta escala é construída a partir da resposta a cinco questões dos questionários aos alunos e aos pais (“Número de Livros em Casa”, “Número de Livros Infantis em Casa”, “Número de Elementos de Apoio ao Estudo”, por exemplo, Internet ou quarto próprio, “Nível de Escolaridade Mais Elevado dos Pais” e “Ocupação Profissional Mais Elevada dos Pais”).

Sentido de Pertença à Escola

O “Sentido de Pertença à Escola” é uma escala psicométrica cujas pontuações foram estimadas pela ponderação do grau de concordância dos alunos (de Concordo completamente’ a Discordo completamente’) com afirmações sobre o que estes pensavam sobre a sua escola (por exemplo, “Gosto de estar na escola”, “Sinto orgulho por estar na minha escola”, entre outras).

Competências Precoces de Literacia

As “Competências Precoces de Literacia” refletem as competências de literacia de leitura que os alunos revelavam ter à entrada no 1.º ciclo. Esta escala foi operacionalizada por seis questões colocadas aos pais/encarregados de educação sobre quão bem (de Muito bem’ a Nada bem’) os seus educandos conseguiam realizar atividades de literacia de leitura (por exemplo, “Reconhecer a maioria das letras do alfabeto”, “Ler algumas palavras”, “Escrever algumas palavras”, entre outras).

Ênfase da Escola no Sucesso Académico dos Alunos

A escala “Ênfase da Escola no Sucesso Académico dos Alunos” foi obtida através das respostas dos diretores (de Muito elevado’ a Muito baixo’), a 12 questões relativas à “Compreensão, por parte dos professores, dos objetivos curriculares definidos pela escola”; à “Capacidade dos professores para motivar os alunos”; ao “Envolvimento dos pais nas atividades da escola”; à “Capacidade dos alunos para atingirem os objetivos definidos pela escola”; à “Vontade, por parte dos alunos, de ter sucesso na escola”, entre outros aspetos organizacionais e educativos das escolas.

Alunos Limitam a Instrução nas Aulas

A escala “Alunos Limitam a Instrução nas Aulas” é obtida através das respostas dos professores a um conjunto de sete itens sobre aspetos dos alunos que limitam a sua prática letiva (de Nada’ a Muito’), como por exemplo “Alunos que não possuem conhecimentos ou competências que são pré-requisitos”, “Alunos ausentes das aulas”, “Alunos indisciplinados”, “Alunos com incapacidades nas funções mentais, emocionais ou psicológicas”, “Alunos com deficiências nutricionais”, entre outras.

Estimação da Literacia de Leitura

A pontuação de literacia de leitura de cada aluno foi estimada por métodos psicométricos baseados na Teoria da Resposta ao Item e na Imputação de Valores Omissos por Regressão em Variáveis Latentes (TIMSS & PIRLS International Study Center, 2017). Estas estimativas, produzidas pela equipa de psicometristas do consórcio da IEA-Boston College, são apresentadas na base de dados do PIRLS, disponibilizada ao público em dezembro de 2017, sob a forma de cinco valores plausíveis para o desempenho em literacia de leitura de cada aluno. Os valores plausíveis são estimativas da pontuação que seria de esperar que um determinado aluno obtivesse em literacia de leitura, considerada a sua aptidão latente nas finalidades/processos de leitura avaliados e variáveis de contexto que caracterizam o aluno. As estimativas estandardizadas do desempenho dos alunos são depois convertidas na escala do PIRLS, estabelecida na primeira edição do estudo, de forma a variarem entre 0 e 1000 pontos, com média de 500 pontos e desvio-padrão de 100 pontos (Foy & Yin, 2017).

Análise Estatística

A identificação das variáveis, escalas e índices capazes de predizer a variação dos desempenhos em literacia de leitura dos alunos portugueses no PIRLS 2016 foi feita através de um conjunto de regressões lineares hierárquicas para valores plausíveis, depois de removidos os preditores com multicolinearidade forte (VIF >5; ver Marôco, 2014). Os modelos apresentados neste estudo não incluem, por este motivo, todas as variáveis, índices e escalas psicométricas que se podem encontrar no relatório internacional (Martin, Mullis, Hooper, et al., 2017). Na primeira etapa da análise estimou-se o coeficiente de correlação intraclasses (ICC), considerando-se que um ICC superior ou igual a 10% era indicador de efeitos de cluster que é necessário considerar para obter estimativas eficientes dos parâmetros do modelo de regressão linear (Marôco, 2014).

Na segunda etapa da análise foram analisados modelos lineares hierárquicos com ordenadas aleatórias e declives homogéneos entre escolas, com centragem dos preditores de nível 1 (alunos) e de nível 2 (escolas). A validação dos pressupostos dos modelos, nomeadamente a distribuição normal dos resíduos, é assegurada pela elevada dimensão da amostra e consequente aplicação do teorema do limite central (Marôco, 2014). Todas as análises foram efetuadas com o software mPlus (v. 7.2, Muthén & Muthén, Los Angeles). Consideraram-se estatisticamente significativos os efeitos com p < 0,05. Dimensões de efeito ou coeficientes de regressão estandardizados inferiores a 0,10 (β< 0,10), ainda que estatisticamente significativos, foram considerados irrelevantes neste nível de análise.

Resultados

Na edição de 2016 do estudo PIRLS, os alunos portugueses alcançaram uma pontuação média de 528 pontos (SEM = 2,3), um valor significativamente inferior à pontuação média de 541 pontos (SEM = 2,6) alcançada no PIRLS 2011 (Mullis, Martin, Foy, et al., 2017). Apesar de a pontuação média de Portugal estar significativamente acima do ponto médio da escala do PIRLS (500 pontos), na escala ordenada dos participantes, os alunos portugueses ficaram posicionados na 30.ª posição, não diferindo significativamente dos seus congéneres de Israel, Espanha ou Bélgica. Esta posição está significativamente abaixo da de outros países europeus como a Irlanda (4.ª posição, com 567 pontos) ou a Itália (17.ª posição, com 548 pontos), mas significativamente acima da França (35.ª posição, com 511 pontos) (Mullis, Martin, Foy, et al., 2017). Os resultados seguintes destacam as variáveis/características dos alunos, famílias, professores e escolas que conseguem predizer, com significância estatística e dimensão de efeito considerável, as variações dos desempenhos dos alunos portugueses em literacia de leitura no PIRLS 2016.

Variações Intrarregiões e Intraescolas

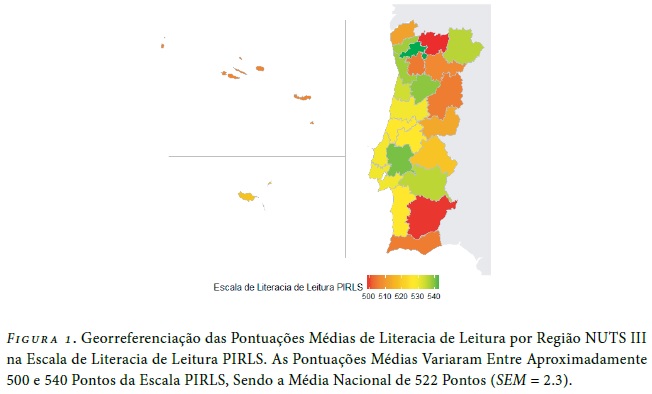

Na primeira fase da análise, estimou-se a variabilidade entre regiões NUTS III e entre escolas. A estimativa do coeficiente de correlação intraclasses (ICC) para as 25 regiões NUTS III foi de 0,03, indicando que apenas 3% da variação dos resultados de literacia de leitura do PIRLS dos alunos portugueses pode ser explicada por diferenças regionais. Esta observação é suportada pela reduzida variabilidade relativa dos desempenhos médios observadas por região NUTS III (Figura 1).

Georreferenciação das pontuações médias de literacia de leitura por região NUTS III na escala de Literacia de Leitura PIRLS. As pontuações médias variaram entre aproximadamente 500 e 540 pontos da escala PIRLS, sendo a média nacional de 522 pontos (SEM = 2.3).

Ao nível das escolas – o nível hierárquico imediatamente inferior aos das regiões NUTS III no quadro de amostragem – observou-se um ICC = 0,19. Dezanove por cento da variabilidade dos resultados dos alunos é explicada por diferenças entre escolas (características das escolas e das respetivas populações escolares). A dimensão do ICC para as escolas recomenda, assim, que a análise hierárquica seja feita a dois níveis: ao nível elementar (N1) do aluno e da respetiva família; ao nível hierárquico superior (N2) das escolas.

Características dos Alunos e das Famílias

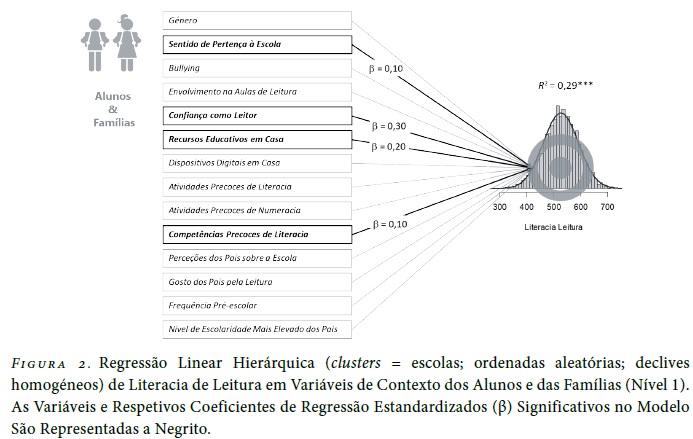

Na análise linear hierárquica ao nível do aluno/família consideraram-se como preditores da variação dos desempenhos dos alunos as variáveis/escalas de caracterização dos alunos e das suas famílias, produzidas pela IEA, e centradas pela média nacional (isto é, o valor basal do modelo reporta-se ao aluno «médio» nacional). O modelo estatístico ajustado considerou ordenadas aleatórias e os efeitos das variáveis em cada escola foram considerados efeitos fixos (declives homogéneos). A Figura 2 ilustra as variáveis consideradas na análise de nível 1. A negrito apresentam-se as variáveis estatisticamente significativas, isto é, as variáveis capazes de explicar a variação dos desempenhos entre alunos, aninhados nas respetivas escolas, para além da variação natural decorrente das características individuais dos alunos.

Regressão Linear Hierárquica (clusters = escolas; ordenadas aleatórias; declives homogéneos) de Literacia de Leitura em Variáveis de Contexto dos Alunos e das Famílias (Nível 1). As variáveis e respetivos coeficientes de regressão estandardizados (β) significativos no modelo são representadas a negrito.

O modelo linear hierárquico ajustado explica 29% da variação dos desempenhos dos alunos aninhados nas 218 escolas que participaram no PIRLS 2016. A variável (escala) com maior poder preditor foi a “Confiança como Leitor” (β = 0,30; p < 0,001). A análise indica que quanto mais confiante é o aluno em leitura, melhores são os resultados. Por cada unidade (desvio-padrão) adicional na escala de confiança, o desempenho dos alunos aumenta 0,3 desvios-padrão (i.e., 30 pontos na escala do PIRLS).

A segunda variável com maior poder preditor para explicar as variações dos desempenhos dos alunos foi a escala de “Recursos Educativos em Casa” (β = 0,20; p < 0,001). Por cada unidade (desvio-padrão) adicional na escala de “Recursos Educativos em Casa”, o desempenho dos alunos aumenta 0,2 desvios-padrão (i.e., 20 pontos na escala do PIRLS).

Com efeito reduzido, mas estatisticamente significativo, identificaram-se as variáveis “Sentido de Pertença à Escola” (β = 0,10; p < 0,001) e “Competências Precoces de Literacia” (β = 0,10; p < 0,001). Quanto maior o sentido de pertença à escola, isto é, quanto mais os alunos gostam de estar e ser parte da escola, melhor o seu desempenho em leitura (o aumento de uma unidade da escala de “Sentido de Pertença à Escola” corresponde a um aumento de 10 pontos na escala do PIRLS). De forma semelhante, quanto maiores as competências precoces de literacia, melhor o desempenho dos alunos em leitura. O aumento de uma unidade desta escala traduz-se no aumento de 10 pontos na escala do PIRLS. É de realçar que outras variáveis, como, por exemplo, a frequência do ensino pré‑escolar ou o nível de escolaridade mais elevado dos pais, estão incluídas implícita ou explicitamente noutros preditores (por exemplo, a frequência do pré-escolar reflete-se implicitamente nas “Competências Precoces de Literacia”; o nível de escolaridade mais elevado dos pais está explicitamente incluído na escala “Recursos Educativos em Casa”), pelo que os seus efeitos não alcançam relevância prática ou estatística quando incluídas nos modelos de previsão em conjunto com outros preditores mais relevantes.

Características das Escolas e dos Professores

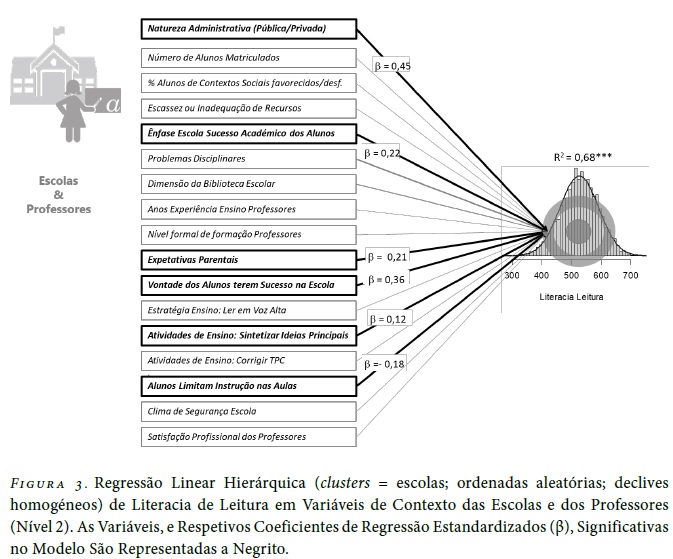

A Figura 3 ilustra algumas das variáveis de nível da escola e dos professores recolhidas através dos questionários preenchidos pelo diretor da escola e pelo(s) professor(es) da(s) turma(s) avaliada(s). Ao nível da escola/professor, a variável com maior poder explicativo da variação observada nos desempenhos de literacia de leitura dos alunos de 4.º ano foi a “Natureza Administrativa da Escola” (pública/privada). O modelo prevê que quando se passa de uma escola pública para uma escola privada, o desempenho em literacia de leitura aumenta 45 pontos (β = 0,45; p< 0,001). O segundo melhor preditor do desempenho dos alunos foi a questão que avalia, segundo os professores, a “Vontade dos Alunos terem Sucesso na Escola” (β = 0,36; p < 0,001). Por cada desvio-padrão desta variável, o desempenho de literacia de leitura aumenta 36 pontos na escala do PIRLS.

Regressão Linear Hierárquica (clusters = escolas; ordenadas aleatórias; declives homogéneos) de Literacia de Leitura em Variáveis de Contexto das Escolas e dos Professores (Nível 2). As variáveis, e respetivos coeficientes de regressão estandardizados (β), significativas no modelo são representadas a negrito.

As “Expectativas Parentais Quanto aos Resultados dos Alunos” (β = 0,21; p = 0,08) e a “Ênfase da Escola no Sucesso Académico dos Alunos” (β = 0,22; p = 0,10) são dois preditores que explicaram de forma moderada a variação dos desempenhos dos alunos em literacia de leitura.

Finalmente, das variáveis que avaliam as práticas e as estratégias letivas dos professores e as suas limitações destacam-se, como estatisticamente significativas e com dimensão de efeito não desprezível, as “Atividades de Ensino: Síntese das Ideias Principais” (β = 0,12; p = 0,10) e as limitações às práticas letivas decorrentes de dificuldades ou limitações dos alunos (β = -0,18; p = 0,10). Outras variáveis, que isoladamente podem ajudar a explicar parte da variação dos desempenhos dos alunos (por exemplo, a Satisfação profissional dos professores, Anos de experiência profissional, Dimensão da biblioteca escolar, Dimensão da escola/turma), não se revelaram estatisticamente significativas quando o efeito dessas variáveis foi analisado, em simultâneo, num conjunto mais vasto de variáveis e escalas psicométricas que caracterizam o clima e recursos organizacionais das escolas e as estratégias e as práticas dos seus professores.

Análise conjunta das variáveis de alunos, famílias, professores e escolas

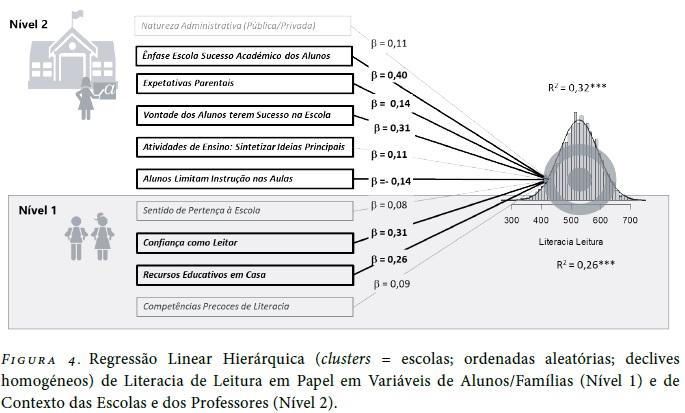

As análises anteriores permitiram identificar um conjunto de variáveis medidas ao nível dos alunos e respetivas famílias (ver Figura 1), e ao nível das escolas e professores (ver Figura 2), capazes de explicar parcialmente a variação observada nos desempenhos dos alunos em literacia de leitura em papel. Contudo, é de referir que os alunos, as suas expectativas, capacidades e competências, os recursos e as atividades familiares de literacia e as expectativas parentais não existem de forma independente das experiências, perceções, recursos e clima das escolas e das expectativas, práticas, experiências e atividades de ensino dos professores. Assim, apenas a análise integrada destas variáveis, ainda que num modelo relativamente simplista que não considera interações entre variáveis de diferentes níveis, permite uma visão integrada e parcimoniosa das variáveis e dos diferentes stakeholders que explicam as variações dos desempenhos de literacia de leitura entre alunos e entre escolas. A Figura 4 ilustra o efeito e a significância das variáveis de nível 1 (alunos e famílias) e de nível 2 (escolas e professores), identificadas nas análises por nível, como sendo os melhores preditores das variações observadas no desempenho dos alunos.

Regressão Linear Hierárquica (clusters = escolas; ordenadas aleatórias; declives homogéneos) de Literacia de Leitura em Papel em Variáveis de Alunos/Famílias (Nível 1) e de Contexto das Escolas e dos Professores (Nível 2).

A análise conjunta das variáveis nos diferentes níveis pode produzir interpretações diferentes daquelas que se podem deduzir, erroneamente, da análise em cada um dos níveis. Por exemplo, a natureza administrativa da escola (pública/privada) era, na análise isolada das variáveis de escola, aquela que melhor predizia a variação dos resultados da literacia de leitura em papel. Contudo, quando o efeito dessa variável de escola é combinado com o efeito das variáveis do aluno (p.e., os recursos educativos em casa e as atividades precoces de literacia), o seu poder explicativo da variação dos desempenhos dos alunos deixa de ser significativo (β = 0,11; p = 0,41). Esta observação desmistifica a aparente superioridade das escolas privadas, nomeadamente dos modelos de gestão e capacitação profissional dos seus professores, relativamente às escolas públicas, no que se refere ao desempenho dos alunos portugueses no PIRLS 2016. A escola privada é, geralmente, frequentada por alunos com mais recursos educativos em casa e com mais atividades precoces de literacia. Quando a natureza da população escolar é devidamente considerada, as diferenças dos desempenhos dos alunos entre as duas naturezas administrativas (público/privado) das escolas portugueses deixam de ser estatisticamente significativas.

A análise conjunta dos preditores de nível 1 (alunos e famílias) e de nível 2 (escola e professores) destaca: a “Confiança como Leitor” (β = 0,31; p < 0,01) e os “Recursos Educativos em Casa” (β = 0,26; p < 0,01) como variáveis dos alunos e das famílias; a “Ênfase da Escola no Sucesso Académico dos Alunos” (β = 0,40; p < 0,01) e a “Vontade dos Alunos terem Sucesso na Escola” (β = 0,31; p < 0,01) como variáveis de escola e dos professores. No seu conjunto, estas são as variáveis capazes de melhor predizer a variação dos desempenhos de literacia de leitura no PIRLS 2016. Na segunda linha de importância, com significância estatística e dimensão de efeito considerável, aparecem as variáveis dos professores referentes às expectativas parentais sobre o desempenho dos seus educandos (β = 0,14; p < 0,01), às atividades de ensino assentes no resumo das ideias principais do texto (β = 0,11; p = 0,05) e as limitações às práticas de ensino por dificuldades dos alunos (β = -0,14; p < 0,01).

Discussão e conclusão

Contrariamente à tendência internacional, em que se observou o crescimento da literacia de leitura, Portugal registou uma quebra significativa entre 2011 e 2016 (Mullis, Martin, Foy, et al., 2017). Os dados do PIRLS permitem identificar as variáveis que podem definir – à luz do PIRLS – um bom leitor. O PIRLS providencia, além dos desempenhos dos alunos em literacia de leitura, informação sobre variáveis de contexto dos alunos, das famílias, dos professores e das escolas. Estas variáveis são organizadas em escalas e índices que permitem, entre outros propósitos, identificar características dos alunos, famílias, professores e escolas capazes de explicar a variação dos resultados obtidos pelos alunos. Na análise destas variáveis é necessário ter em conta que o estudo PIRLS, tal como outros estudos de amostragem em larga escala, é um estudo correlacional. Isto é, as variáveis de contexto são observadas simultaneamente com os resultados dos alunos. Não existe qualquer manipulação experimental destas variáveis nem qualquer tipo de controlo temporal. Por este motivo, qualquer inferência de causalidade deve ser devidamente acautelada: se existir uma relação causal entre duas variáveis, então elas estarão correlacionadas; mas a existência de correlação ou de variação concorrente entre duas variáveis não é suficiente para demonstrar uma relação de causalidade. Interpretações dos resultados não escoradas nestas precauções poderão ser pouco mais do que mera fantasia estatística.

A análise comparativa das variáveis que caracterizam os alunos com melhores desempenhos no relatório internacional destaca a superioridade das raparigas relativamente aos rapazes, o que não se observou em Portugal (dados do relatório internacional não apresentados). Aliás, Portugal, a par com Macau, são os dois únicos participantes onde as diferenças de literacia de leitura entre rapazes e raparigas não são significativas (Mullis, Martin, Foy, et al., 2017). À semelhança dos resultados internacionais, o efeito de atividades precoces de literacia, como por exemplo a leitura frequente de livros em casa (Sénéchal, 2012), tem sido confirmada noutros estudos (Martini & Sénéchal, 2012) e edições do PIRLS, nomeadamente em países europeus (Araújo & Costa, 2015; Costa & Araújo, 2017 Netten, Voeten, Droop, & Verhoeven, 2014). As expectativas parentais relativamente ao sucesso académico dos seus educandos é também um preditor de melhores desempenhos referido com frequência na literatura (ver e.g. Martini & Sénéchal, 2012). Ainda em termos globais, os alunos que frequentavam escolas mais bem equipadas e de estatuto socioeconómico mais elevado (escolas de natureza administrativa privada) obtêm melhores desempenhos(Mullis, Martin, Foy, et al., 2017). Esta observação já tinha sido confirmada na Dinamarca, França e Alemanha na edição de 2011 do PIRLS (Stancel-Piątak, Mirazchiyski, & Desa, 2013). Em Portugal, na edição de 2016 do PIRLS, também se observou esta tendência; contudo, quando os recursos educativos em casa (um indicador do estatuto socioeconómico das famílias) são tidos em consideração, o efeito da natureza administrativa (público/privado) perde a significância estatística. Estes resultados permitem concluir que as escolas privadas não têm à partida características organizacionais superiores às das escolas públicas; têm, sim, alunos com mais e melhores recursos facilitadores das aprendizagens. À semelhança da tendência internacional, também em Portugal as escolas com maior ênfase no sucesso académico e onde os professores têm expectativas elevadas relativamente ao desempenho dos alunos têm alunos com melhores desempenhos no PIRLS (Mullis, Martin, Foy, et al., 2017). Contudo, este efeito não parece uniforme em todos os países participantes. No estudo de Stancel-Piatak et al. (2013), apenas na França, à semelhança de Portugal, se observou um efeito positivo e significativo da ênfase no sucesso académico no desempenho dos alunos. De forma semelhante, o sentimento de pertença à escola é um bom preditor de melhores desempenhos, quer a nível nacional, quer internacional(Mullis, Martin, Foy, et al., 2017). Dados de outras edições do PIRLS confirmam a importância das estratégias de ensino orientadas para a aprendizagem. Cheung et al. (2017) observaram que os resultados dos alunos de Hong Kong na edição do PIRLS de 2006 estavam significativamente correlacionados com as estratégias e atividades dos professores no ensino da leitura. Contudo, o efeito positivo das estratégias dos professores sobre a literacia dos alunos não parece ser universal. Por exemplo, Shiel e Eivers (2009), ao analisar os resultados do PIRLS 2006, encontraram relações contraditórias entre o desempenho dos alunos e diferentes tipos de estratégias e recursos usados pelos professores de diferentes países. Claramente, não existe um denominador comum a todos os países e sistemas de ensino que permita identificar, de forma clara, quais os recursos e estratégias ao nível dos alunos, famílias, professores e escolas que melhores aprendizagens produzem. A necessidade de análises intrapaíses, como a que se realizou neste trabalho, é evidente.

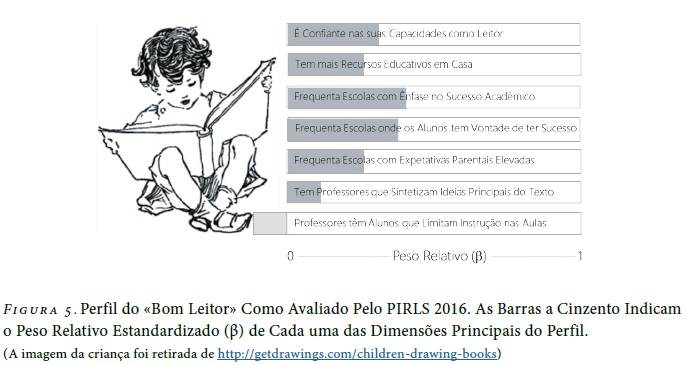

A análise estatística efetuada, considerando os efeitos hierárquicos das diferentes variáveis que caracterizam os alunos, as suas famílias, escolas e professores, permite construir o perfil dos alunos com melhores desempenhos no PIRLS 2016. O “bom leitor” PIRLS é um aluno confiante nas suas capacidades (de leitura), que provém de agregados familiares com mais recursos educativos (incluindo nível de escolaridade mais elevado dos pais), que se sente integrado na escola e que demonstra ter competências de literacia emergente à entrada no 1.º ciclo de escolaridade. Os alunos com melhores desempenhos frequentam escolas onde é dada maior ênfase ao sucesso escolar dos alunos, cujos professores sentem que os seus alunos têm vontade de ter bons desempenhos académicos e que promovem atividades de ensino da leitura que incluem a síntese das ideias principais dos textos lidos. Frequentam também escolas em que os impedimentos às práticas de ensino devido a limitações cognitivas, comportamentais, físicas e nutricionais dos alunos são reduzidos. Por sua vez, os pais/encarregados de educação destes alunos têm expectativas elevadas sobre o desempenho dos seus educandos. A Figura 5 resume estas conclusões e sintetiza o perfil do “bom leitor” como avaliado pelo PIRLS 2016.

A realização de estudos internacionais de avaliação de alunos por amostragem de larga escala permite a recolha de informação sobre os desempenhos dos alunos num teste que reflete uma proposta de curriculum universal (como é o caso, por exemplo, do PIRLS, ou do TIMSS) ou um conjunto de conhecimentos e competências que estudantes de um determinado grupo etário devem apresentar (por exemplo, os alunos de 15 anos do PISA). Estes dados, se devidamente contextualizados nas limitações deste tipo de estudos e nas características socioeconómicas dos países e respetivos sistemas educativos, são úteis para suportar desenvolvimentos curriculares, políticas e práticas educativas nas escolas e salas de aula. Os resultados do PIRLS 2016 são particularmente relevantes para o contexto nacional, na medida em que se observou um retrocesso da literacia de leitura dos alunos do 4.º ano, comparativamente à penúltima edição do estudo (PIRLS, 2011), e que urge recuperar. A promoção de práticas de leitura e de confiança como leitor, a ênfase no sucesso académico, a redução das limitações cognitivas e comportamentais dos alunos no ensino e as estratégias de ensino centradas no resumo das ideias principais do texto, durante o ensino básico, apresentam-se como fundamentais para o desenvolvimento pessoal e académico dos alunos portugueses. Esta fase do desenvolvimento das competências de leitura é fundamental já que até aqui (10 anos) as crianças aprendem a ler, e a partir daqui precisam de ler e compreender o que leem para aprender.

Referências

Araújo, L., & Costa, P. (2015). Home book reading and reading achievement in EU countries: the Progress in International Reading Literacy Study 2011 (PIRLS). Educational Research and Evaluation, 21(5–6), 422–438. doi:10.1080/13803611.2015.1111803 [ Links ]

Cheung, W. M., Lam, J. W. I., Au, D. W. H., So, W. W. Y., Huang, Y., & Tsang, H. W. H. (2017). Explaining student and home variance of Chinese reading achievement of the PIRLS 2011 Hong Kong. Psychology in the Schools, 54(9), 889–904. doi:10.1002/pits.22041 [ Links ]

Costa, P., & Araújo, L. (2017). Skilled students and effective schools: Reading achievement in Denmark, Sweden, and France. Scandinavian Journal of Educational Research, 1–15. https://doi.org/10.1080/00313831.2017.1307274 [ Links ]

Ebbs, D., & Wry, E. (2017). Translation and layout verification for PIRLS 2016. In I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–15). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-7.html [ Links ]

Foy, P., & Yin, L. (2017). Scaling the PIRLS 2016 achievement data. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–38). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-12.html [ Links ]

Hooper, M., & Fishbein, B. (2017). Developing the PIRLS 2016 context questionnaires. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–8). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-2.html [ Links ]

Hooper, M., Mullis, I. V. S., & Martin, M. O. (2015). PIRLS 2016 context questionnaire framework. In I. V. S. Mullis, & M. O. Martin (Eds.), PIRLS 2016 assessment framework (2nd ed., pp. 31–53). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/pirls2016/downloads/P16_FW_Chap2.pdf [ Links ]

Johansone, I. (2017). Survey operations procedures in PIRLS 2016. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–26). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-6.html [ Links ]

Marôco, J. (2014). Análise estatística com o SPSS Statistics (6.ª ed.). Pêro Pinheiro: ReportNumber. [ Links ]

Martin, M. O., Mullis, I. V. S., & Foy, P. (2017). Assessment design for PIRLS, PIRLS literacy, and ePIRLS in 2016. In I. V. S. Mullis & M. O. Martin (Eds.), PIRLS 2016 assessment framework (2nd ed., pp. 55–69). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/pirls2016/downloads/P16_FW_Chap3.pdf [ Links ]

Martin, M. O., Mullis, I. V. S., Hooper, M., Yin, L., Foy, P., Fishbein, B., & Liu, J. (2017). Creating and interpreting the PIRLS 2016 context questionnaire scales. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–106). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-14.html [ Links ]

Martini, F., & Sénéchal, M. (2012). Learning literacy skills at home: Parent teaching, expectations, and child interest. Canadian Journal of Behavioural Science, 44(3), 210–221. doi :10.1037/a0026758 [ Links ]

Mullis, I. V. S. (2016, November 14). TIMSS turns 20. Administered at BC, it's the longest running, large-scale assessment of math and science education in the world [Web post]. Disponível em: https://www.bc.edu/bc-web/bcnews/nation-world-society/education/timss-20th-anniversary-LSOE.html [ Links ]

Mullis, I. V. S., Martin, M. O., Foy, P., & Hooper, M. (2017). PIRLS 2016 international results in reading. Obtido em 4 janeiro 2018 de http://timssandpirls.bc.edu/pirls2016/international-results/ [ Links ]

Mullis, I. V. S., Martin, M. O., Goh, S., & Prendergast, C. (2017). PIRLS 2016 Encyclopedia. Obtido em 4 janeiro de http://timssandpirls.bc.edu/pirls2016/encyclopedia/

Mullis, I. V. S., Martin, M. O., & Sainsbury, M. (2015). PIRLS 2016 reading framework. In I. V. S. Mullis & M. O. Martin (Eds.), PIRLS 2016 assessment framework (2nd ed., pp. 13–31). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 5 janeiro 2018 de https://timssandpirls.bc.edu/pirls2016/downloads/P16_FW_Chap1.pdf [ Links ]

Mullis, I. V. S., & Prendergast, C. O. (2017). Developing the PIRLS 2016 achievement items. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–29). Boston. Obtido em 6 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-1.html [ Links ]

Netten, A., Voeten, M., Droop, M., & Verhoeven, L. (2014). Sociocultural and educational factors for reading literacy decline in the Netherlands in the past decade. Learning and Individual Differences, 32, 9–18. doi:10.1016/j.lindif.2014.02.002 [ Links ]

Rodrigues, M. L., Alçada, I., Calçada, T., & Mata, J. (2017). Apresentação de resultados do projeto Aprender a ler e a escrever em Portugal’ (relatório de progresso). Obtido em 8 janeiro 2018 de http://www.epis.pt/upload/documents/592d4bcd461d4.pdf

Sénéchal, M. (2012). Child language and literacy development at home. In B. H. Wasik (Ed.), Handbook on family literacy (2nd ed., pp. 38–50). New York: Routledge. [ Links ]

Shiel, G., & Eivers, E. (2009). International comparisons of reading literacy: What can they tell us? Cambridge Journal of Education, 39(3), 345–360. doi:10.1080/03057640903103736 [ Links ]

Stancel-Piątak, A., Mirazchiyski, P., & Desa, D. (2013). Promotion of reading and early literacy skills in schools: A comparison of three European countries. European Journal of Education, 48(4), 498–510. doi:10.1111/ejed.12050 [ Links ]

TIMSS & PIRLS International Study Center. (2017). PIRLS 2016 achievement scaling. In M. O. Martin, I. V. S. Mullis, & M. Hooper (Eds.), Methods and procedures in PIRLS 2016 (pp. 1–9). Boston: TIMSS & PIRLS International Study Center. Lynch School of Education, Boston College and International Association of the Evaluation of Educational Achievement. Obtido em 6 janeiro 2018 de https://timssandpirls.bc.edu/publications/pirls/2016-methods/chapter-11.html [ Links ]

Viana, C. (2017, 12 janeiro). Educação. Maus resultados nas competências de leitura no 4.º ano: A culpa é dos currículos ou dos professores? Público. Obtido em 6 de janeiro 2018 de https://www.publico.pt/2017/12/06/sociedade/noticia/falhas-na-formacao-de-professores-ajudaram-a-descida-de-resultados-os-alunos-1795041 [ Links ]

Recebido: fevereiro 2018

Aceite para publicação: outubro 2018

Endereço para Correspondência

Toda a correspondência relativa a este artigo deve ser enviada para: João Marôco ISPA-Instituto Universitário Rua Jardim do Tabaco, 44, 1149-041 Lisboa. E-mail: jpmaroco@ispa.pt

Notas

[1]A nomenclatura NUTS foi criada pelo Eurostat, no início da década 1970, com o objetivo de harmonizar as estatísticas dos vários países da Comunidade Europeia em termos de recolha, compilação e divulgação de estatísticas regionais. As NUTS subdividem-se em três níveis (NUTS I, NUTS II, NUTS III), definidos de acordo com critérios populacionais, administrativos e geográficos comuns aos estados europeus. Neste artigo é o nível hierárquico mais baixo, segundo o qual Portugal é dividido em 25 regiões (NUTS III) que correspondem às 23 "Entidades Intermunicipais" de Portugal continental, à "Região Autónoma dos Açores" e à "Região Autónoma da Madeira".

[2]Itens de resposta construída pelos alunos.

[3]Ver Hooper et al. (2015) e Martin, Mullis, Hooper, et al. (2017), para uma descrição de todas as escalas e índices usados no PIRLS 2016